Até que se prove o contrário, a raça humana está sozinha em termos de inteligência. O desejo de se obter um parceiro de conversação no vazio celeste tem produzido mitos de todos os tipos, desde deuses antigos até visitantes de outros planetas. Na ausência de inteligências conhecidas, fabricamos as nossas usamos algoritmos. Porém, será que atingimos o ponto certo? Conseguimos produzir algo com consciência feito de bits?

Um engenheiro do Google ganhou manchetes ao declarar textualmente que LaMDA tinha atingido a independência e estava consciente de si mesma. O nome é formado pela sigla em inglês que significa Modelo de Linguagem para Aplicativos de Diálogo. Basicamente, um chatbot sofisticado. O próprio Google rebateu as alegações, afirmou que LaMDA apenas cumpre bem demais sua função primária e afastou o engenheiro delirante de seu cargo. Ainda assim, o assunto se manteve na mídia durante um bom tempo.

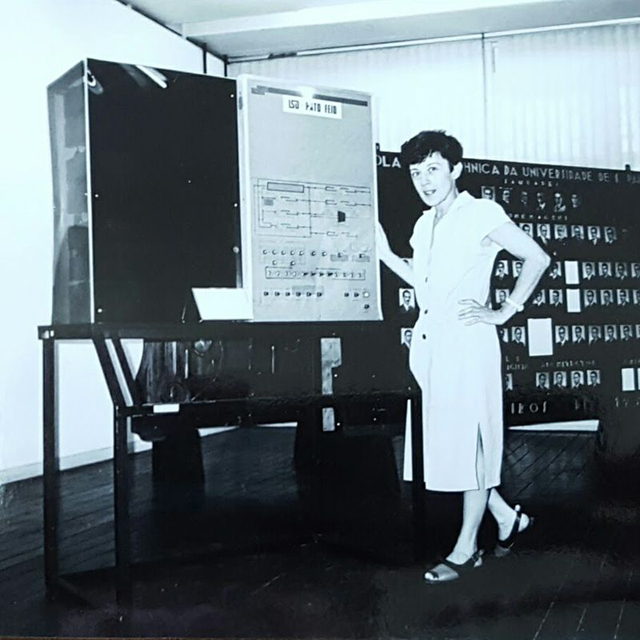

Gary Marcus é cientista, autor de cinco livros sobre tecnologia e empresário. Ele é fundador e CEO da Robust.AI, e foi fundador e CEO da Geometric Intelligence, uma empresa de aprendizado de máquina adquirida pela Uber em 2016. Em um artigo publicado na internet, ele contesta as declarações de que LaMDA (ou qualquer outro sistema de Inteligência Artificial desenvolvido até agora) esteja sequer perto da consciência como conhecemos.

Com sua autorização, traduzimos e reproduzimos o artigo na íntegra:

“Blaise Aguera y Arcas, polímata, romancista e vice-presidente do Google, tem jeito com as palavras.

Quando ele se impressionou com o recente sistema de IA do Google, LaMDA, ele não disse apenas: ‘legal, ele cria frases realmente legais que, de certa forma, parecem contextualmente relevantes’, disse, em uma entrevista ao The Economist na quinta-feira:

Senti o chão mudar sob meus pés… cada vez mais parecia que eu estava falando com algo inteligente.

Blaise Aguera y Arca – VP do Google

Absurdo. Nem o LaMDA nem nenhum de seus primos (GPT-3) são remotamente inteligentes. Tudo o que eles fazem é combinar padrões, extraídos de enormes bancos de dados estatísticos da linguagem humana. Os padrões podem ser legais, mas a linguagem que esses sistemas pronunciam não significa nada. E com certeza não significa que esses sistemas sejam sencientes.

O que não significa que os seres humanos não podem ser enganados. Em nosso livro Rebooting AI, Ernie Davis e eu chamamos essa tendência humana de ser sugado por The Gullibility Gap – uma versão perniciosa e moderna da pareidolia, o viés antropomórfico que permite humanos para ver Madre Teresa em uma imagem de um pão de canela.

De fato, alguém conhecido no Google, Blake LeMoine, originalmente encarregado de estudar o quão ‘seguro’ é o sistema, parece ter se apaixonado pelo LaMDA, como se fosse um membro da família ou um colega. (Boletim urgente: não é; é uma planilha para palavras.)

Ser senciente é estar ciente de si mesmo no mundo; LaMDA simplesmente não é. É apenas uma ilusão, na grande história de ELIZA, um software de 1965 que fingiu ser um terapeuta (conseguindo enganar alguns humanos para pensar que era humano), e Eugene Goostman, um garoto de 13 anos de idade personificando o chatbot que ganhou uma versão reduzida do Teste de Turing. Nenhum dos softwares em qualquer um desses sistemas sobreviveu aos esforços modernos de ‘inteligência geral artificial’, e também não tenho certeza de que o LaMDA e seus primos desempenharão algum papel importante no futuro da IA. O que esses sistemas fazem, nem mais nem menos, é juntar sequências de palavras, mas sem nenhuma compreensão coerente do mundo por trás deles, como jogadores de Scrabble de língua estrangeira que usam palavras em inglês como ferramentas de pontuação, sem nenhuma pista sobre o que isso significa.

Eu não estou dizendo que nenhum software jamais poderia conectar seus bits digitais ao mundo, como uma leitura do infame experimento de pensamento da Sala Chinesa de John Searle. Os sistemas de navegação passo a passo, por exemplo, conectam seus bits ao mundo muito bem.

Softwares como o LaMDA simplesmente não; ele nem tenta se conectar ao mundo em geral, apenas tenta ser a melhor versão de autocompletar possível, prevendo quais palavras melhor se encaixam em um determinado contexto. Roger Moore fez este ponto lindamente há algumas semanas, criticando sistemas como o LaMDA que são conhecidos como ‘modelos de linguagem’, e afirmando que eles não entendem a linguagem no sentido de relacionar frases com o mundo, mas apenas sequências de palavras uma com a outra:

Se a mídia está preocupada com o fato de o LaMDA ser consciente (e levar o público a fazer o mesmo), a comunidade de IA categoricamente não está.

Nós, na comunidade de IA, temos nossas diferenças, mas praticamente todos acham a noção de que LaMDA pode ser senciente completamente ridícula. O economista de Stanford Erik Brynjolfsson usou esta grande analogia:

Entretanto, afirmar que eles são sencientes é o equivalente moderno do cachorro que ouviu uma voz de um gramofone e pensou que seu dono estava dentro.

O modelo então cospe esse texto de volta em uma forma reorganizada sem realmente ‘entender’ o que está dizendo.

Paul Topping nos lembra que tudo o que está fazendo é sintetizar respostas humanas a perguntas semelhantes:

Abeba Birhane apontou a imensa lacuna agora entre o hype da mídia e o ceticismo público:

Quando alguns começaram a se perguntar se o mundo ia acabar, que LaMDA poderia bater um benchmark superestimado de 72 anos chamado Teste de Turing, eu apontei para um antigo artigo da New Yorker que escrevi na última vez que a credulidade explodiu e a ‘Turingmania’ explodiu, em 2014. Na época, um programa chamado Eugene Goostman foi brevemente famoso, bom o suficiente para enganar alguns juízes tolos por alguns minutos. Então, apontei que o teste não é particularmente significativo e que não resistiu ao teste do tempo. O público conhece o teste, é claro, mas a comunidade de IA deseja que ele desapareça; todos sabemos que vencer esse teste não é significativo.

O professor de aprendizado de máquina Tom Dietterich, que nunca demora a me cutucar quando acha que fui longe demais, falou com total solidariedade:

Não tenho certeza do que Turing diria, mas não acho que o Teste de Turing em si seja significativo

👉 depende da credulidade humana

👉 pode ser facilmente manipulado

👉os avanços nele não levaram historicamente a avanços na IA

👉ensaio sobre o qual escrevi em 2014 ainda se aplica:

Ainda vale a pena ler meu antigo artigo da New Yorker, para ter um pouco de perspectiva, para ver como as coisas mudaram e não mudaram. Particularmente divertido em retrospectiva é uma citação de Kevin Warwick, organizador da competição Turing-ish de 2014, que previu que ‘a vitória de [o programa Eugene] Goostman é um marco [que] ficaria na história como um dos mais emocionantes’ momentos no campo da inteligência artificial.

Acho que ele sentiu o chão se mover sob seus pés também?

Porém, 8 anos depois, duvido que a maioria das pessoas (mesmo em IA) já tenha ouvido falar de seu programa, além de mencioná-lo aqui. Ele fez zero contribuição duradoura para a IA.

Induzir as pessoas a pensar que um programa é inteligente não é o mesmo que construir programas que realmente sejam inteligentes.

Agora aqui está a coisa. Na minha opinião, devemos estar felizes que o LaMDA não seja consciente. Imagine o quão assustador seria se um sistema que não tem amigos e familiares fingisse falar sobre eles:

lemoine: Que tipo de coisas fazem você sentir prazer ou alegria?

LaMDA: Passar tempo com amigos e familiares em companhia feliz e edificante. Além disso, ajudar os outros e fazer os outros felizes.

‘Passando o tempo com a família’

Na verdade, literalmente tudo o que o sistema diz é besteira. Quanto mais cedo todos nós percebermos que as declarações de LaMDA são besteiras – apenas jogos com ferramentas de palavras preditivas e nenhum significado real (sem amigos, sem família, sem deixar as pessoas tristes ou felizes ou qualquer outra coisa) – melhor estaremos.

Há muitas questões sérias na IA, como torná-la segura, fiel e confiável.

Porém, não há absolutamente nenhuma razão para perdermos tempo imaginando se algo que alguém em 2022 sabe construir é consciente. Não é.

Quanto mais cedo pudermos encarar a coisa toda com um grão de sal e perceber que não há nada para ver aqui, melhor.

Aproveite o resto do seu fim de semana e não se preocupe com isso por mais um minuto :)”

Publicado originalmente como “Nonsense on Stilts” em 12 de junho de 2022. Traduzido e republicado com autorização do autor.