“Vi com meus próprios olhos, que a terra há de comer”: no tempo de nossas avós, essa frase significava um atestado incondicional de autenticidade para determinado fato. Podia ser algo fantástico como o avistamento de um lobisomem ou mais prosaico como o vizinho casado de braços dados com uma amante. Em ambos os casos, era “ver para crer”. O olhar era uma ferramenta incorruptível de uma realidade palpável. A tecnologia mudou isso: vivemos na era dos deep fakes.

O uso de aprendizado de máquina permitiu que se revivesse o personagem Chaves para um comercial de televisão ou que o rapper Kendrick Lamar se transformasse em Will Smith, aperfeiçoando e muito o truque que Michael Jackson usou lá atrás com “Black and White” (quem lembra?). Temos então o marketing e a arte se apropriando de nosso olhar e ludibriando nossos cérebros.

Entretanto, como todas as tecnologias já desenvolvidas nesse planeta desde o fogo, há sempre alguém disposto a utilizar o conhecimento para fins maliciosos. Um caso pioneiro envolveu o CEO de uma empresa europeia que teve sua voz sintetizada para enganar um diretor de filial, através de áudios falsificados, gerando uma transferência indevida de mais de um milhão de dólares pelo câmbio atual. Para ficar apenas em mais dois exemplos recentes, “vimos” golpistas se fazendo passar por Elon Musk para impulsionar criptomoedas fraudulentas e o presidente ucraniano, Volodymyr Zelensky, declarando rendição à Rússia, em uma evidente peça de guerra psicológica

O uso nocivo de deep fakes, tanto de vídeo quanto de áudio, já chamou a atenção do FBI. Um relatório divulgado no ano passado (PDF) sobre “conteúdo sintético” alerta sobre os riscos de nações hostis e agentes criminosos empregarem essa tecnologia em larga escala em um futuro próximo, em até 18 meses. O futuro desse relatório é agora. O poder de manipulação da realidade a partir de informações forjadas escapou da Caixa de Pandora.

Deep Fakes ameaçam segurança digital

Nos últimos dois anos, em virtude da pandemia, explodiram as videoconferências. Serviços como o Zoom alvoreceram para patamares nunca dantes imaginados. Em contrapartida, nunca se produziu tanto material em áudio e vídeo quanto agora, dados que podem ser alimentados em algoritmos para criar réplicas digitais de pessoas reais. A indústria do deep fake cresceu na mesma proporção que as videoconferências e isso tem chamado a atenção dos especialistas de segurança: criminosos eletrônicos receberam de bandeja um farto material para ser aproveitado em golpes.

Nos últimos dois anos, a cena do deep fake foi removida da mão de amadores e entusiastas e se tornou um serviço lucrativo para o crime. Da mesma forma que aconteceu com os ransomwares, que eram a iniciativa de hackers ou grupos isolados e agora são uma indústria que oferece ataques como serviço, o mesmo processo está acontecendo com os deep fakes, acessível por meio de assinaturas pagas disponíveis para quem quiser pagar.

O mais preocupante agora é que o uso da tecnologia está transcendendo a manipulação de fatos para se tornar uma ferramenta de burlar defesas digitais. Toda uma comunidade já está formada na chamada dark web, compartilhando e negociando ferramentas, conhecimento e alvos, com o objetivo de comprometer sistemas.

Já há múltiplos relatos de uso de deep fakes em tentativas de phishing, seja pelo telefone, seja através de plataformas de comunicação de times, como Slack ou Microsoft Teams. Os criminosos eletrônicos se aproveitaram do home office ou do regime híbrido para simular funcionários e manipular sua entrada em sistemas, em operações em que se consegue reproduzir o mesmo ritmo, a mesma cadência de voz e sotaque de executivos em posição de comando. Esse recurso, associado a técnicas mais tradicionais de engenharia social, facilita a obtenção de credenciais e acessos a sistemas de alta importância, permitindo o furto de dados, espionagem industrial ou implantação de malware.

Essa ameaça se torna ainda mais grave quando se lida com sistemas de autenticação baseados em biometria mal implementados. A partir do momento que existe uma tecnologia capaz de imitar com quase perfeição a imagem da face ou o áudio da voz de um usuário, verificações de segurança baseadas nesses pilares perdem sua confiabilidade.

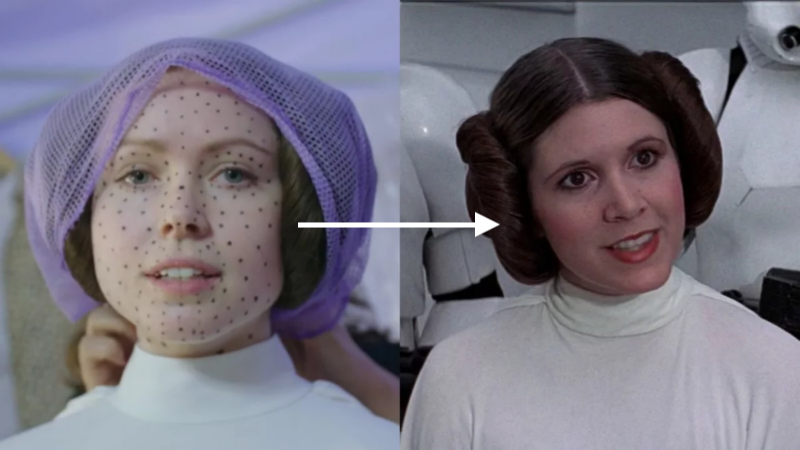

É necessário aprimorar esses mecanismos de biometria para reconhecer tais tentativas de fraude, identificando os sinais deixados pela manipulação por algoritmos. A Microsoft é uma das empresas que já trabalham em algoritmos criados com o fim específico de identificar o que o olho humano não treinado não consegue mais: reconhecer indícios de que outro algoritmo foi responsável por aquela imagem. O que vemos agora é uma espécie de “corrida armamentista” entre sistemas de aprendizado profundo, em que temos aqueles criados para mascarar e aqueles criados para desmascarar, uma corrida que já vimos anteriormente entre sistemas CAPTCHA e bots de internet.

Deep Fakes ameaçam a imagem pessoal

A Kaspersky alerta para outro uso criminoso dos deep fakes: danos à imagem pessoal de suas vítimas. A empresa de segurança aponta para os riscos de manipulação digital em campanhas políticas para atingir adversários, mas também para o chamado pornô de vingança ou mesmo crimes de chantagem e extorsão, falsificando evidências contra seus alvos.

Bruno Sartori, um dos pioneiros do deep fake no Brasil, é também um dos principais críticos sobre o uso nocivo da tecnologia. De forma descontraída, ele publicou no Instagram um vídeo falso do presidente Jair Bolsonaro dançando funk, exaltando a vitória de seu maior oponente nas próximas eleições. Sartori pede que os eleitores fiquem espertos. A brincadeira (que pode ser encarada como depreciativa) não esconde ser uma cena forjada. Da mesma forma, Ciro Gomes, outro candidato a presidência em 2022, publicou em seu Twitter um deep fake misturando Bolsonaro com o filme Esqueceram de Mim. Mais uma vez, é nítida a montagem na provocação, porém a tecnologia do deep fake pode e certamente será usada de forma mais sutil durante o pleito de 2022, confundindo o eleitor e manchando reputações.

De acordo com a Kaspersky, fora do espectro político, nada impede que essas mesmas técnicas sejam empregadas para chantagear executivos de alto escalão ou empresários com vídeos e declarações falsificadas que podem impactar gravemente seus negócios. Até o momento, não há um caso concreto registrado, mas esse silêncio é comum nessa modalidade criminosa.

Infelizmente, vídeos pornográficos gerados por algoritmo são o ponto de origem da tecnologia de deepfake. Ainda que sua prática esteja sendo banida em plataformas e aplicativos e serviços do gênero sejam derrubados com frequência, esse uso original se mantém ativo. A nova face da prática é que esse conteúdo sintético de cunho pornográfico está sendo utilizado para coagir, chantagear ou pura e simplesmente prejudicar mulheres. A jornalista indiana Rana Ayyub, que conduzia uma série de reportagens sobre abuso de poder em seu país, foi vítima de uma campanha sistemática nesse sentido, em 2018. Ela não está sozinha: um estudo divulgado no ano seguinte (PDF) constatou que cerca de 96% dos deepfakes circulando na internet estavam relacionados a pornografia com mulheres de forma não consensual, ou seja, suas vítimas não autorizaram o uso de suas imagens para criação de cenas eróticas que nunca aconteceram.

Exterminador do Futuro

O dilema dos deep fakes apenas se agrava em uma sociedade que já era vítima das fake news e que se engaja facilmente com manchetes sensacionalistas e não busca o contexto das notícias que compartilha. O deep fake provoca a mesma resposta emocional, porém amplificada pela corrompida credibilidade do “ver para crer” que já não funciona mais.

O cineasta James Cameron, um dos grandes magos do uso de imagens digitais no cinema, responsável pelo robô de metal líquido em Exterminador do Futuro 2 ou por todo o mundo digital 3D de Pandora em Avatar, se preocupa gravemente com uma sociedade que parece incapaz de distinguir o real do ilusório. Em entrevista para a BBC, ele aponta os problemas que estamos vivendo: “os ciclos de notícias acontecem tão rápido e as pessoas respondem tão rapidamente que você pode ter um grande incidente entre o intervalo entre quando o deep fake surge e quando é exposto como falso”.

James Cameron também desabafou sobre as paranoias que emergem na internet: “as teorias da conspiração são muito complicadas. As pessoas não são tão boas, os sistemas humanos não são tão bons, as pessoas não podem guardar um segredo para salvar suas vidas, e a maioria das pessoas em posições de poder são fantoches desajeitados (…) O fato de pensarmos que eles poderiam realisticamente bolar esses esses enredos complexos? Eu não compro nada dessa porcaria! Bill Gates não está realmente tentando colocar um microchip em você com a vacina contra a gripe!”.

O cineasta sugere um sistema ancestral, mas infalível contra conteúdo sintético ou mentiras tradicionais: o conceito da Navalha de Occam. O princípio filosófico prega que, dadas diferentes explicações para um mesmo fenômeno ou evento, a explicação simples tende a ser a mais provável de estar correta.

Saindo da teoria e indo para a prática, a Kaspersky oferece uma lista de características que podem ajudar a reconhecer um deep fake diante de seus olhos:

- movimento brusco

- iluminação instável, mudando de um quadro para o outro

- mudanças no tom da pele

- modo de piscar os olhos estranho ou nenhum piscar

- lábios mal sincronizados com a fala

- elementos digitais na imagem

Porém, a mesma empresa de segurança alerta que essas dicas funcionam somente no momento atual da tecnologia, em que imperfeições ainda estão presentes nos algoritmos. A tendência para a próxima década é que o conteúdo sintético se torne cada vez mais indistinguível para o olho humano, o que exigirá muito cuidado, bom senso e filosofia para reconhecer inverdades, assim como ferramentas de segurança aprimoradas e uma legislação adequada contra o uso nocivo da tecnologia.